基于tensorflow开发框架,搭建softmax模型完成mnist分类任务。

本文的完整代码托管在我的Github PnYuan - Practice-of-Machine-Learning - MNIST_tensorflow_demo,欢迎访问。

1.任务背景

1.1.目的

以MNIST手写数字识别为课题,研究基本深度学习方法的应用。本文先从Softmax模型切入,以熟悉tensorflow下mnist任务的开发流程。之后的文章将陆续引入MLP、CNN等模型,以达到更优异的识别效果。

1.2.数据集

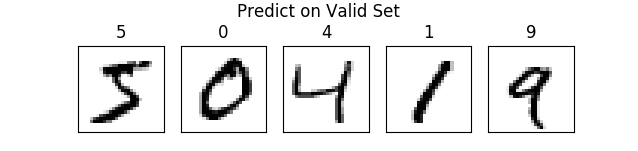

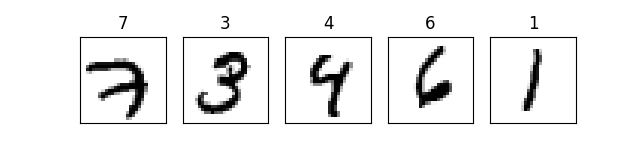

MNIST任务是图像识别领域经典的“Helloworld”。在其所提供的数据集中,包含了6w个训练样本和1w个测试样本,均为黑白图片,大小28×28,以灰度矩阵的形式存放,数值取浮点数“0~1”对应“白~黑”。给出一些图片(X)及对应标注(Y)如下图所示:

2.实验过程

2.1.数据预研

MNIST数据的一些基本信息如下:

输入:image - 784 的向量 --> image size [28*28]

输出:label - int(0-10)

#train:55k

#valid:5k

#test:10k

基于tensorflow对mnist数据进行加载与测试的示例代码如下:

1 | mnist = input_data.read_data_sets('../data/mnist_data/',one_hot=True) |

2.2.Softmax建模

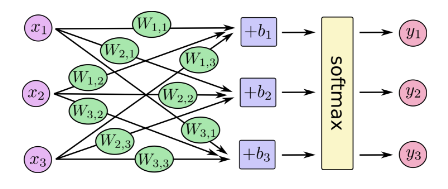

Softmax回归可看作是Logistic回归模型向多分类任务的拓展,其模型可描述如下图:

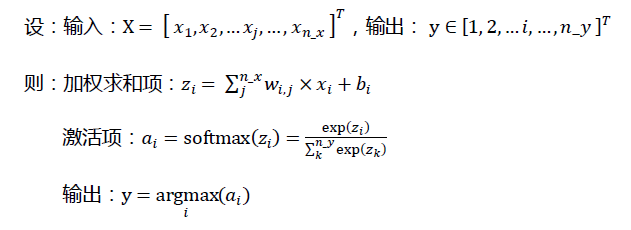

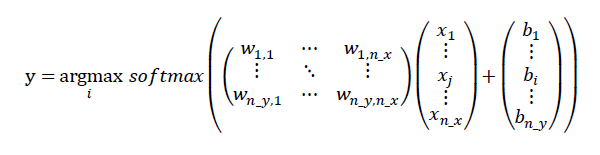

其公式表达如下:

写成向量化形式:

权值 W 和偏置 b 是这里需要学习的参数。

采用tensorflow可以轻松构建出Softmax模型,示例代码如下:

1 | #========== Softmax Modeling ==========# |

2.3.训练与测试

通过构建tensorflow对话(session),给定输入x,运行由x-->y的计算图(Computation Graph),后台可简单完成训练过程。这里采用的是简单的mini-batch Gradient Descent优化策略。

模型的训练样例代码如下:

1 | y_ = tf.placeholder("float", [None, 10]) # placeholder of label |

在验证集与测试集上评估所学模型的效果,以预测准确率(accuracy)为指标,得出结果如下:

valid accuracy 0.927

test accuracy 0.9208

可以看出,Softmax模型在经过一定时间的训练之后,达到了九成的分类准确率。与MNIST官网给出的线性分类器(单层NN)的准确级别相近。

3.实验小结

这里采用tensorflow开发框架搭建了Softmax多分类模型,实现了超过90%的测试准确率。模型的搭建以及训练测试过程十分简便。据tensorflow官网所述,使用多层神经网络等更复杂的模型还可进一步提升分类效果,接下来的文章,将对此进行跟进。